目录

- 1 api.py http多用户并行

- 1.1 fastapi并行

- 1.2 fastapi多线程并行

- 2 api.py websocket多用户并行

- 3 web_demo.py多用户并行

ChatGLM对话模型基本环境配置和部署请参考上一篇博文《ChatGPT平替-ChatGLM环境搭建与部署运行》,地址为“https://www.jb51.net/article/283295.htm”。但是,默认部署程序仅支持单用户访问,多用户则需要排队访问。测试过相关的几个Github多用户工程,但是其中一些仍然不满足要求。本节将系统介绍如何实现多用户同时访问ChatGLM的部署接口,包括http、websocket(流式输出,stream)和web页面等方式,主要目录如下所示。

(1)api.py http多用户并行

(2)api.py websocket多用户并行(流式输出,stream)

(3)web_demo.py多用户并行

本节所涉及程序可根据文中描述自行编写或替换,也可在“https://download.csdn.net/download/suiyingy/87742178”进行下载,文中所有程序均在其中。

1 api.py http多用户并行

1.1 fastapi并行

ChatGLM-6B工程的api.py是基于fastapi编写的http post服务程序。具体介绍及调用方式请参考上一篇博文。运行程序后,当多用户同时调用该http接口时,程序需要排队执行,即当前用户指令需要等待上一用户获取结果完成之后才进行执行。

实现接口并行的关键在于去除create_item的async,相应程序如下所示,该函数段由RdFast小程序自动生成。我们可以根据如下描述编写程序,也可前往“https://download.csdn.net/download/suiyingy/87742178”进行下载,对应下载后的api_http_one_worker.py文件。

#该函数段由RdFast小程序自动生成

from pydantic import BaseModel

class User(BaseModel):

prompt: str

history: list

@app.post(\”/http/noasync\”)

def create_item(request: User):

global model, tokenizer

json_post_raw = request.dict()

json_post = json.dumps(json_post_raw)

json_post_list = json.loads(json_post)

prompt = json_post_list.get(\’prompt\’)

history = json_post_list.get(\’history\’)

max_length = json_post_list.get(\’max_length\’)

top_p = json_post_list.get(\’top_p\’)

temperature = json_post_list.get(\’temperature\’)

response, history = model.chat(tokenizer,

prompt,

history=history,

max_length=max_length if max_length else 2048,

top_p=top_p if top_p else 0.7,

temperature=temperature if temperature else 0.95)

now = datetime.datetime.now()

time = now.strftime(\”%Y-%m-%d %H:%M:%S\”)

answer = {

\”response\”: response,

\”history\”: history,

\”status\”: 200,

\”time\”: time

}

log = \”[\” + time + \”] \” + \’\”, prompt:\”\’ + prompt + \’\”, response:\”\’ + repr(response) + \’\”\’

print(log)

torch_gc()

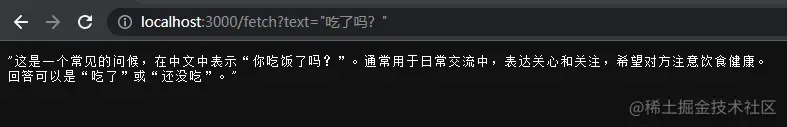

我们通过输入“你好”来进行测试,并模拟三个用户进行同时访问。修改之前三个用户获取返回结果所需时间分别为2.08s、4.05s和6.02s,而修改之后获取结果所需时间分别为6.73s、6.78和6.88s。修改前程序顺序执行,最后一个用户获取结果所需时间为6.02s。修改后程序是并行执行的,三个用户几乎同时获得访问结果。

由于模型参数在多个线程之间是共享的,且多线程状态下程序会交替运行,因此多线程状态下获取结果的总时间反而增加了。因此,这种修改并不适合http模式,比较适合于websocket流式输出。模拟多用户调用的测试程序如下所示。

import json

import time

import requests

import threading

def get_ans(id, prompt):

t0 = time.time()

headers = {\’Content-Type\’: \’application/json\’}

url = \’http://IP:Port/http/noasync\’

data = {\’prompt\’: prompt, \’history\’: []}

data = json.dumps(data)

reponse = requests.post(url=url, data=data, headers=headers)

print(id, \’耗时为:\’, round(time.time() – t0, 2), \’s,结果为:\’, reponse .text)

if __name__ == \’__main__\’:

t1 = threading.Thread(target=get_ans, args=(\’线程1\’, \’你好\’))

t2 = threading.Thread(target=get_ans, args=(\’线程2\’, \’你好\’))

t3 = threading.Thread(target=get_ans, args=(\’线程3\’, \’你好\’))

t1.start()

t2.start()

t3.start()

1.2 fastapi多线程并行

fastapi多线程通过启动参数workers来进行控制。如果程序直接将api.py中的workers设置为大于1的数值,即“uvicorn.run(app, host='0.0.0.0', port=8000, workers=2)”,那么会报错“WARNING: You must pass the application as an import string to enable 'reload' or 'workers'.”,报错后程序退出并停止执行。正确修改为“uvicorn.run('api:app', host='0.0.0.0', port=8000, workers=2)”,其中api表示当前python文件名称。

这相当于各个线程分别运行api.py文件的app,运行次数由workers决定。从这里可以看到,程序并不能识别’__main__’函数中的变量,因此要把模型定义放在全局位置,如下所示,否则会报错误“NameError: name 'model' is not defined”。

app = FastAPI()

tokenizer = AutoTokenizer.from_pretrained(\”chatglm-6b-int4-qe\”, trust_remote_code=True)

model = AutoModel.from_pretrained(\”chatglm-6b-int4-qe\”, trust_remote_code=True).half().cuda()

model.eval()

在多线程情况下,类似上一节,无论是否使用asnc,程序运行时间基本一致。但是,基本显存会随着线程数量增多而增加。实际运行时,单个线程应需要10GB左右显存,包括模型加载和推理。各个线程数量下的模型加载显存如下所示。而1.1节的方法中单个线程仅需要3939MB。

Workers=1, 7329MBWorkers=2, 17875MBWorkers=3, 24843MBWorkers=4, 31811MBWorkers=5, 38779MB

我们可以根据上述描述编写程序,也可前往“https://download.csdn.net/download/suiyingy/87742178”进行下载,对应下载后的api_http_three_worker.py文件。

2 api.py websocket多用户并行

Fastapi websocket的创建方法如下所示,该示例程序来源于RdFast小程序自动生成。

#该示例程序来源于RdFast小程序自动生成。

from fastapi import FastAPI, WebSocket, WebSocketDisconnect

app = FastAPI()

connected_websockets = {}

@app.websocket(\”/ws/{client_id}\”)

async def websocket_endpoint(websocket: WebSocket, client_id: str):

await websocket.accept()

connected_websockets[client_id] = websocket

try:

while True:

# 接收客户端websocket发送过来的信息

data = await websocket.receive_text()

# 将接收到的信息通过所有已连接的websocket广播给其他客户端

for ws in connected_websockets.values():

await ws.send_text(f\”Client {client_id}: {data}\”)

except WebSocketDisconnect:

# 连接断开时,从已连接的客户端中移除

del connected_websockets[client_id]

将上述程序与ChatGLM结合即可实现ChatGLM的websocket api接口。示例程序如下所示:

@app.websocket(\”/ws/{client_id}\”)

async def websocket_endpoint(ws: WebSocket, client_id: str):

await ws.accept()

print(\’已连接\’)

try:

while True:

# 接收客户端websocket发送过来的信息

data = await ws.receive_text()

print(\’收到消息:\’, data)

resp0 = \’\’

for response, history in model.stream_chat(tokenizer, data, [], max_length= 2048,top_p= 0.7, temperature= 0.95):

print(\’response:\’, response)

res = response.replace(resp0, \’\’)

resp0 = response

await ws.send_text(res)

await ws.send_text(\'<rdfast stop>\’)#自定义结束符

except WebSocketDisconnect:

print(\’连接已断开\’)

我们可以根据上述描述编写程序,也可前往“https://download.csdn.net/download/suiyingy/87742178”进行下载,对应下载后的api_http_one_worker.py文件。Websocket测试程序如下所示。

from websocket import create_connection

def connect_node(ques):

ans = \’\’

url = \”ws://IP:Port/ws/2\”

ws = create_connection(url)

ws.send(ques)

while True:

try:

recv_text = ws.recv()

print(recv_text)

if \'<rdfast stop>\’ in recv_text:

print(\’break\’)

break

ans += recv_text

except Exception as e:

print(\’except: \’, str(e))

recv_text = ws.recv()

break

print(ans)

ws.close()

connect_node(\’你好\’)

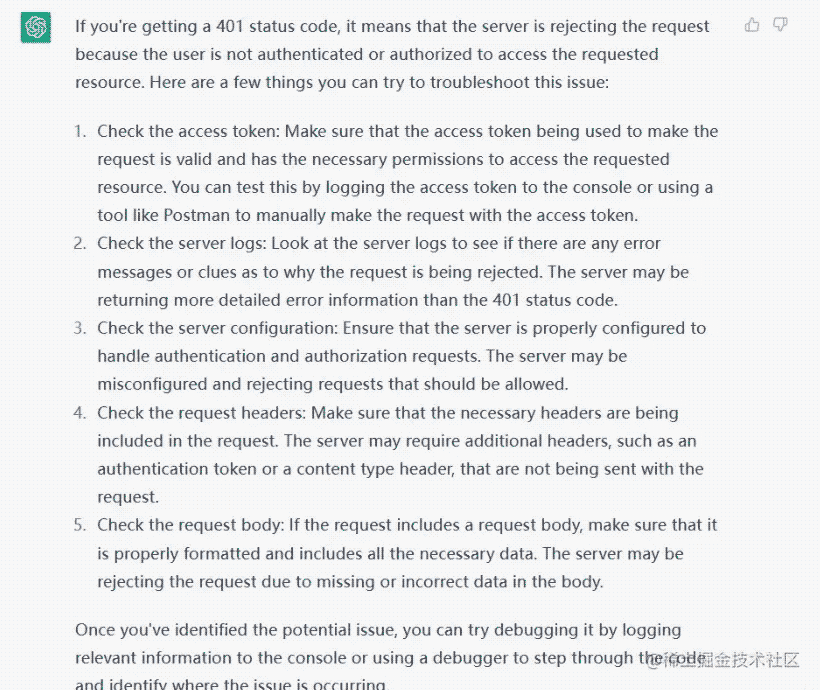

类似http接口,使用async时多用户调用websocket将排队获取结果。此时,程序去除async之后无法获取结果。使用1.2中多线程启动方式则可以实现多用户同时获得结果,程序基本一致,也可参考“https://download.csdn.net/download/suiyingy/87742178”的api_http_three_worker.py。

另外,不同的python包所支持的工作方式不同。例如,websocket-server支持多用户同时调用websocket接口,安装方式为“pip install websocket-server”。运行程序时可能会出现错误提示“KeyError: 'upgrade'”,但这不影响结果获取。websocket-server ChatGLM相应程序见“https://download.csdn.net/download/suiyingy/87742178”的api_ws.py程序。

3 web_demo.py多用户并行

Web_demo.py默认状态下多用户会排队访问,使用下面命令启动时可同时获取结果。concurrency_count表示最多可同时获取结果的用户数,即并发数。max_size表示排队的数量,即最多允许多少个用户处于排队状态。使用时只需将web_demo.py的最后一行替换成如下启动方式即可。Web_demo2.py采用streamlit实现,默认支持多用户同时访问。

demo.queue(

concurrency_count=5,

max_size=500).launch(share=False,

inbrowser=True,

server_name=\”0.0.0.0\”,

server_port=8000)

到此这篇关于ChatGPT平替-ChatGLM多用户并行访问部署的文章就介绍到这了,更多相关ChatGPT平替ChatGLM部署内容请搜索悠久资源网以前的文章或继续浏览下面的相关文章希望大家以后多多支持悠久资源网!

您可能感兴趣的文章:

- linux环境部署清华大学大模型最新版chatglm2-6b图文教程

- macbook安装环境chatglm2-6b的详细过程

- ChatGLM-6B+LangChain环境部署与使用实战

- 基于本地知识的问答机器人langchain-ChatGLM大语言模型实现方法详解

- ChatGPT平替-ChatGLM环境搭建与部署运行效果

- ChatGLM 集成LangChain工具详解

- 基于prompt tuning v2训练好一个垂直领域的chatglm-6b

- 最简化ChatGLM2-6b小白部署教程【windows系统,16G内存即可,对显卡无要求,CPU运行】